Existe uma ideia equivocada, quase um senso comum moderno, de que computação quântica será a solução para todos os paradigmas atuais da computação — como se colocar mais "poder de fogo" resolvesse automaticamente os limites lógicos, matemáticos e estruturais dos sistemas computacionais. Mas isso é, no mínimo, uma meia-verdade perigosa.

A computação não se resume a "processar mais". Processar trilhões de dados por segundo não ajuda em problemas onde o estado, a ordem e a consistência são mais importantes do que velocidade bruta. Isso fica ainda mais evidente quando olhamos para a natureza dos qubits.

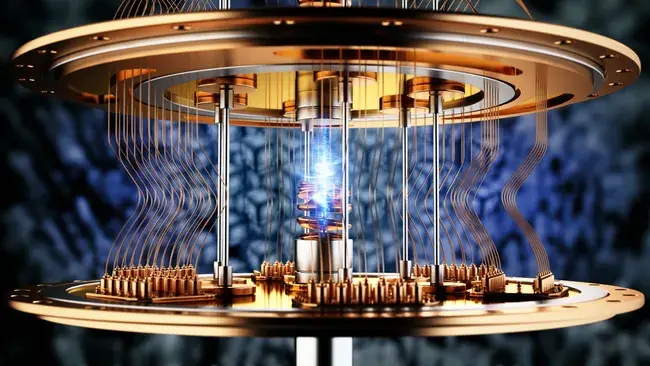

Qubits não são bits rápidos

Diferente do bit clássico (0 ou 1), um qubit opera em superposição — ou seja, ele pode assumir vários estados ao mesmo tempo até ser observado. Isso não significa que temos controle sobre esses estados. Pelo contrário: só temos probabilidades.

Imagine uma TV com milhões de pequenos LEDs que estão constantemente piscando entre aceso e apagado. A cada vez que você olha, a imagem que aparece não é estática, mas resultado da combinação momentânea e única de todos esses LEDs. A repetição desse processo em altíssima velocidade cria a ilusão de uma imagem estável — o mesmo efeito visual de uma hélice de helicóptero girando tão rápido que parece parada.

Esse é o qubit. Não controlamos seu estado diretamente. Apenas observamos colapsos de possibilidades.

Onde a computação quântica realmente brilha?

Em problemas que dependem de fatores probabilísticos, como:

Fatoração de números primos (base de muitos algoritmos de criptografia clássica);

Caminhos ótimos em grafos complexos;

Correlações de grandes volumes em modelos de IA generativa;

E claro, quebra de criptografias baseadas em força bruta.

Porque? Porque a superposição permite avaliar milhões (ou trilhões) de possibilidades simultaneamente, sem precisar iterar uma por uma como um processador clássico faria.

E agora o problema: segurança

Vamos a um exemplo simples: criptografar a string "Hello World" com uma chave AES-256-GCM assinada com uma curva elíptica (ex: secp256k1, usada no Bitcoin). O resultado será um buffer criptografado de 44 a 64 bytes, contendo:

O nonce,

O payload criptografado,

E o tag de verificação GCM.

A chave pública usada na assinatura pode ser derivada do hash criptografado — e embora seja visível, a chave privada que gerou essa assinatura permanece oculta graças à assimetria da curva elíptica.

Agora entra a matemática real:

Uma chave privada do Bitcoin (BIP 39/BIP 44) tem 2.048⁴² possibilidades (24 palavras mnemônicas, 2048 opções por palavra)

Isso dá algo como 2.9e+79 combinações possíveis.

A chave em si (hexadecimal de 64 caracteres) possui 16⁶⁴ combinações, ou seja:

≈ 7.9e+76

(79.228.162.514.264.337.593.543.950.336.000.000.000.000.000.000.000)

Esse número é tão absurdo que, com computadores tradicionais, levaria bilhões de anos para quebrar mesmo com todos os recursos do planeta.

Aí temos um problema.

O que antes era computacionalmente impossível, se torna apenas "altamente improvável". Um salto quântico real permitiria testar bilhões ou trilhões de combinações por segundo — e mesmo assim, não há garantias. Estamos falando de probabilidades e observações, não de precisão determinística. E justamente por isso, a confiança nos sistemas criptográficos se tornaria volátil.

A computação quântica não é só "mais rápido" — é outro paradigma.

Enquanto ela pode sim quebrar alguns modelos criptográficos, ela não resolve o design da computação tradicional.

Estados Intermitentes Não Criam Computação Determinística

Pela natureza intermitente dos qubits, onde o estado só se revela no momento da observação e colapsa para um entre vários possíveis, não há como garantir previsibilidade de execução. Em termos simples: não dá para escrever código determinístico com qubits, porque o comportamento deles não segue lógica binária estável como nos processadores tradicionais.

E essa previsibilidade é fundamental:

É o que permite que qualquer sistema operacional exista.

É o que garante que um loop for vá iterar exatamente 10 vezes.

É o que faz com que um if (x === y) funcione de maneira consistente.

Tudo que você conhece hoje em computação moderna — SO, bancos de dados, navegadores, compressores de vídeo, compiladores — depende de bits com estados estáveis, que se mantêm fiéis ao código-fonte que os controla.

Outro ponto que o senso comum ignora: não basta processar rápido, é preciso ter estrutura para armazenar, recuperar e movimentar os dados. Um processador quântico pode, em tese, testar bilhões de possibilidades por segundo, mas:

Ele não tem RAM tradicional,

Não possui barramento para leitura e escrita direta,

E não existe integração prática com SSDs, NVMe, PCIe, etc.

Ou seja: não adianta um núcleo “super gênio” se ele está isolado numa caverna sem acesso a memória nem rede. A computação moderna é uma orquestra entre processador, memória volátil, armazenamento persistente, controladores, buses e periféricos. O quântico, até hoje, não conversa bem com nenhum desses.

Até que seja possível fazer um qubit se comportar como um byte estável — com 8 bits previsíveis e controláveis — ele será apenas um recurso estatístico, não uma unidade de computação real para uso geral.

E mesmo que isso fosse alcançado, o que você teria?

Um processador... clássico, só que com mais instabilidade.

O processador tradicional moderno tem bilhões de transistores, e por consequência, bilhões de bytes de endereçamento direto. Enquanto isso, o maior processador quântico hoje tem, em teoria, algo próximo de 1 milhão de qubits “sujos” — ou seja, com interferência, instabilidade, sem coerência entre estados e altíssima taxa de erro.

Se você tentar “organizar” esses qubits para comportarem-se como bytes tradicionais, estará apenas restringindo o modelo quântico ao determinismo binário, anulando todo o potencial de superposição. E ainda com desempenho inferior aos chips clássicos.

Em Resumo: Um Propósito Único

Na minha visão, a aplicação mais concreta — e talvez a única viável no curto e médio prazo — para a arquitetura dos processadores quânticos é quebrar criptografia.

E não, não é para roubar sua carteira de Bitcoin.

É para algo muito mais sério: acessar informações de governos, sistemas financeiros globais, infraestrutura crítica, protocolos militares, inteligência estratégica.

Porque é isso que realmente importa em escala global.

E se um dia existir, ou já existir, um processador quântico estável o suficiente para ser o “Enigma moderno”, pode ter certeza de uma coisa:

Você não vai ouvir falar sobre ele tão cedo.

Esse tipo de tecnologia não vira open-source nem entra em keynote da CES. Ela será militarizada, classificada, e só se tornará de uso público décadas depois, quando já estiver obsoleta para quem importa. Foi assim com o GPS, com a comunicação via satélite, com a própria internet.

A computação quântica, com toda sua mística e promessa, não veio para substituir o modelo tradicional, mas sim para atuar em nichos onde o binário falha — e isso, quase sempre, envolve criptografia, simulação quântica e processamento paralelo não determinístico.

Para todo o resto, o bom e velho processador de silício, com seu clock estável, bytes previsíveis e pipeline linear, continua sendo o verdadeiro motor da informática moderna.