O que acontece entre seu “código bonito” e o executável

January 21, 2026

Tem um assunto que as gerações novas de dev parecem ter esquecido: o que um compilador realmente faz . A maioria hoje vive num modo “piloto automático”: roda um comando no terminal e, por magia, a lin...

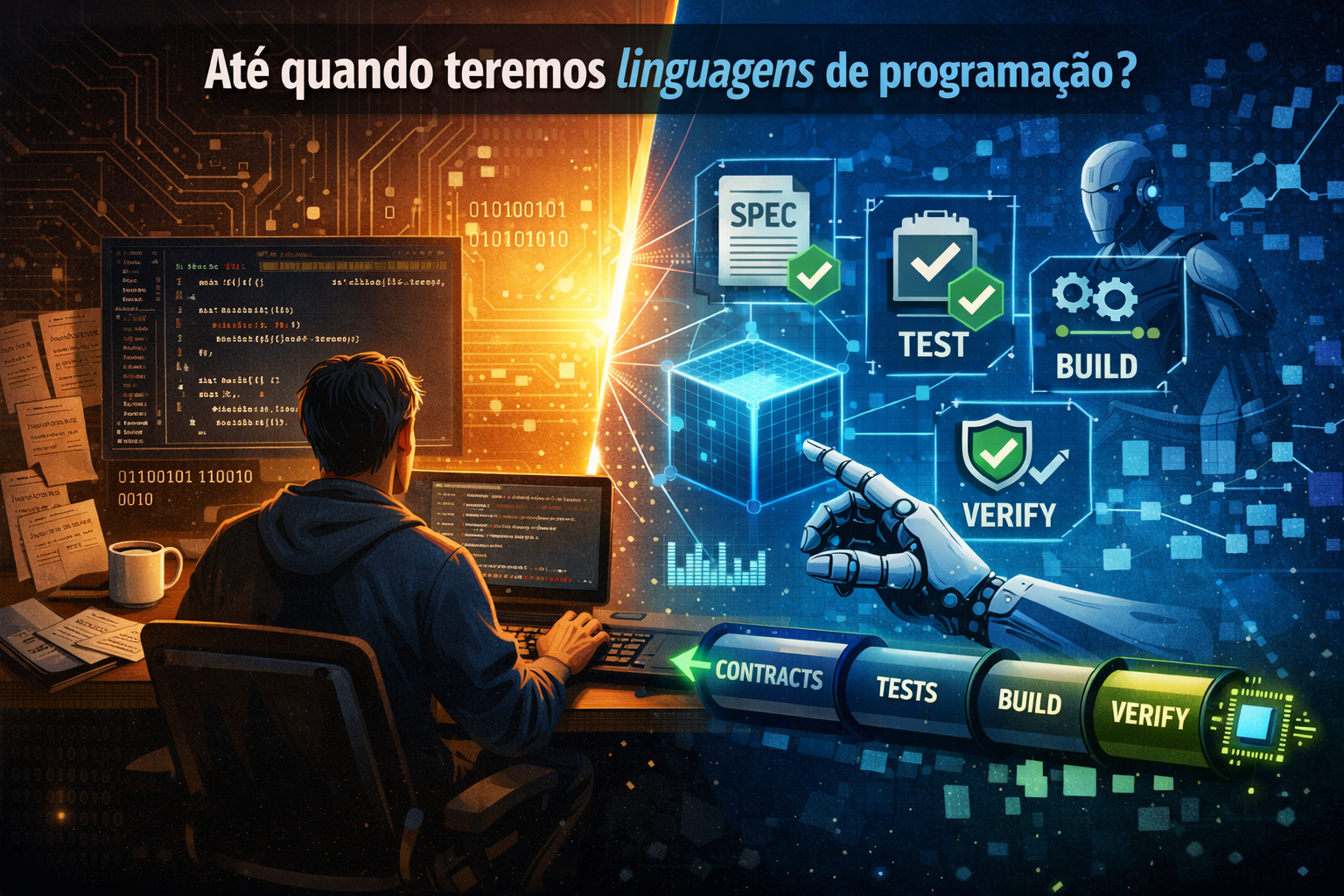

Até quando teremos linguagens de programação?

December 21, 2025

Pra muita gente isso soa como filosofia barata. Pra quem já encostou em compiladores, arquiteturas e infraestrutura de build, a pergunta é bem mais concreta: a linguagem é mesmo o centro do desenvolvimento… ou só a interface que a gente acostumou a usar?

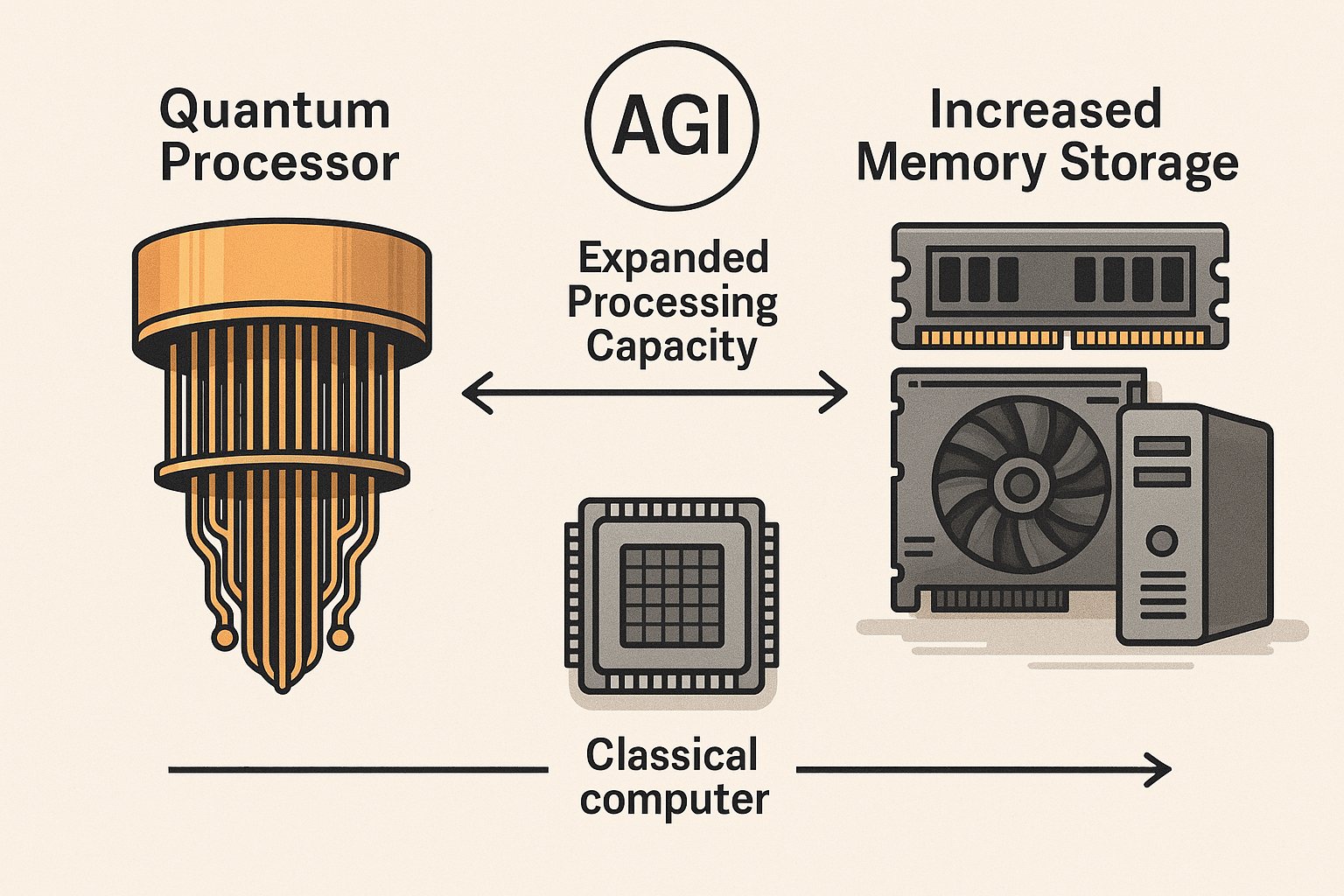

Especialistas sob demanda: o que aprendi treinando meus “experts”

November 7, 2025

Imagina você rodar modelos locais com a mesma qualidade dos grandes modelos de API? essa e a ideia que estou construindo!

Minha tese é simples: especialistas sob demanda vencem generalistas inchados. Em vez de carregar um Frankenstein de 70B parâmetros para “fazer tudo”, eu mantenho um modelo base compacto residente em VRAM e plugo experts leves (LoRA/DoRA/IA³) só quando a tarefa pede. Isso roda em GPU de consumo (8–16 GB), carrega adapters em milissegundos e mantém contexto longo sem custo absurdo. Não é MoE; é composição dinâmica em runtime, com um roteador heurístico que aciona 1–10 experts por consulta.

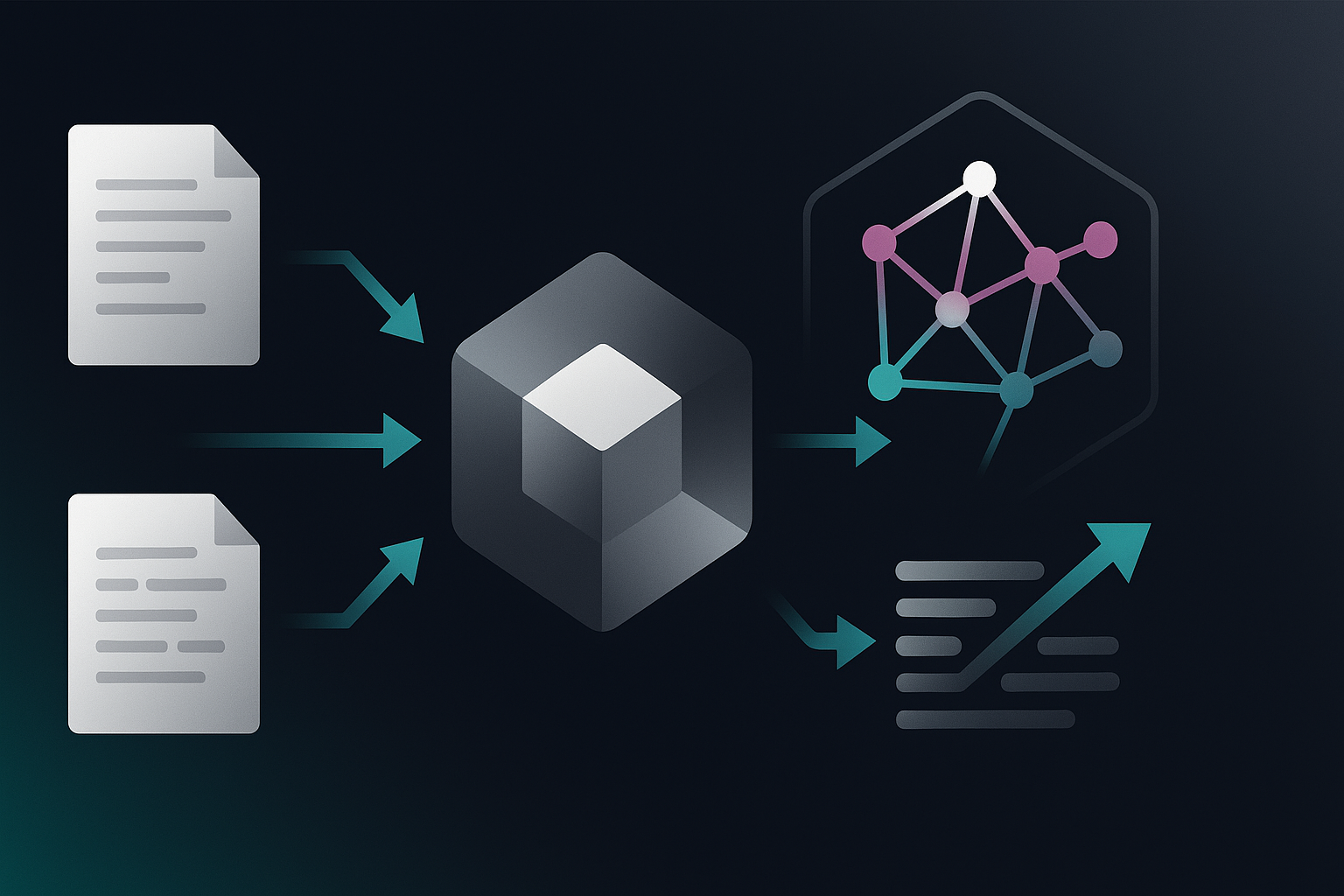

Como tripliquei a precisão do RAG real com Elasticsearch + Vectorizer + Neo4j

October 28, 2025

Banco único é gambiarra elegante. Sistema sério usa três: Elasticsearch (descoberta ampla), Vectorizer MCP (código exato por chunk) e Neo4j (estrutura/relacionamentos). Resultado prático em produção: 95–98% de qualidade percebida, com ~150 ms de latência extra e ~4K tokens por prompt. O custo compensa fácil: 5× de ROI.

Relevância híbrida na prática — do “parecido” ao “importante”, com um layer de raciocínio por cima

October 25, 2025

Por que RAG bom não é só similaridade. Como combinar semântica, sinais, estrutura e tempo — guiados por um layer de raciocínio — produz respostas atuais, explicáveis e baratas. Inclui uma reflexão crítica sobre o modelo de RAG “buscar parecido e torcer”.

Do “RAG hype” ao Vectorizer: o que aprendi construindo meu próprio banco vetorial (em Rust)

October 14, 2025

Eu me frustrei com resultados medianos de RAG no início (GPT-3.5, libs Python, vetores “mágicos”). Resolvi atacar UX, performance e previsibilidade: escrevi um banco vetorial em Rust, medi tudo (benchmarks públicos), padronizei o pipeline (BM25 + HNSW + SQ-8 + chunks 200–500 tokens) e empacotei com APIs REST/MCP/UMICP

A IA Não Vai Substituir Quem Pensa

May 2, 2025

Recentemente tenho refletido sobre o futuro da profissão na qual estou há mais de 20 anos. Por mais que tenha ocupado cargos de gestão, essencialmente sou um programador . Isso me faz pensar: qual é r...

Relevância semântica + Heurística hibrida: O caos da relevância nos RAGs e buscas burras

April 6, 2025

Vamos começar com um título difícil só pra assustar quem chega: "Relevância Semântica Contextualizada com Ponderações Heurísticas Dinâmicas no Pré-processamento de Vetores em Ambientes Cognitivos com ...

A IA vai substituir você !?

April 4, 2025

Essa reflexão é mais sobre você do que propriamente sobre as IAs, mas vamos aos fatos. Venho acompanhando a evolução da área de TI há mais de 23 anos, e lembro de ouvir falar em IAs pelo menos desde e...

A briga entre os artistas e as IAs

January 28, 2023

Hoje eu vou falar um pouco sobre a briga que está acontecendo entre os designers e as inteligências artificiais (IAs), que estão sendo super difundidas por aí e utilizadas pelo público em geral. Eu vo...